Некоторые наши белые проекты тоже попадают под фильтры, мы плотно изучаем и мониторим эту тему, держим руку на пульсе и обмениваемся информацией с зарубежными коллегами. Рано или поздно удается вытаскивать 95% сайтов. Я бы дал следующие рекомендации + важно понимать, что работает комплекс мер, не существует одной конкретной доработки, которая с гарантией выведет сайт из-под фильтра.

Помогают следующие штуки и всегда в комплексе:

- Не бросать сайты. В целом правильная стратегия — растить сайты из года в год и не забивать на сайты. Вытаскиваются любые сайты. Это главное, что нужно понимать.

- Заморочиться над авторством и тем, кто стоит за сайтом (иногда на это может уйти больше 2х недель). Составление красивой и технически-проверяемой легенды сайта – очень важная задача.

Лучше всего создать внушительную страницу «Наши авторы» или «О нас», а также создать странички отдельных авторов с фотографиями, БИО и главное с ссылками на сторонние ресурсы (как соц. сети, так и другие трастовые сайты).

Как правило у нового сайта нет трастовых готовых авторов, поэтому нужно выкручиваться разными способами с ведомом или без ведома реальных людей. Принципы как это делаем мы разбираем в школе https://t.me/gointopru/88.

Также если все страницы авторов сделаны стоит задуматься, чтобы вывести блоки с авторами вначале или в конце постов.

- Обновить дизайн сайта. Любыми способами сделать побольше обновлений: цветовая гамма, расположение логотипа, стили и шрифты. В некоторых случаях – смена темы WordPress.

- Структура сайта: поковырять элементы (например, вывести все посты в меню), вывести контент в сайдбарах, футере. Скорость сайта (опять же плагинами), больше изменений во всех планах.

- Внутренняя перелинковка: в идеале помимо ручной и автоматическую через плагины, например, https://linkwhisper.com/ или https://wordpress.org/plugins/internal-links/.

- Создать категории и теги и оформить их как HUB-pages уделить этому время по максимуму (https://www.swimuniversity.com/hot-tub-care/)

- Поставить плагин Google Indexing API https://rankmath.com/blog/google-indexing-api/ чтобы реакция на изменения была быстрее

- Добавлять комментарии — комменты можно погенерить AI сервисами или взять фрилансеров

- Добавлять новый контент. В идеале – побольше информационного и поменьше коммерческого. Делать с этих страниц перелинковку на все остальные.

- Добавлять новые ссылки — в идеале трастовых. Хороший вариант: подклеить пару Expired Domains с трастовыми ссылками. Подклеивать только не на главную, а на страницу «About Us, например, или «Our Team».

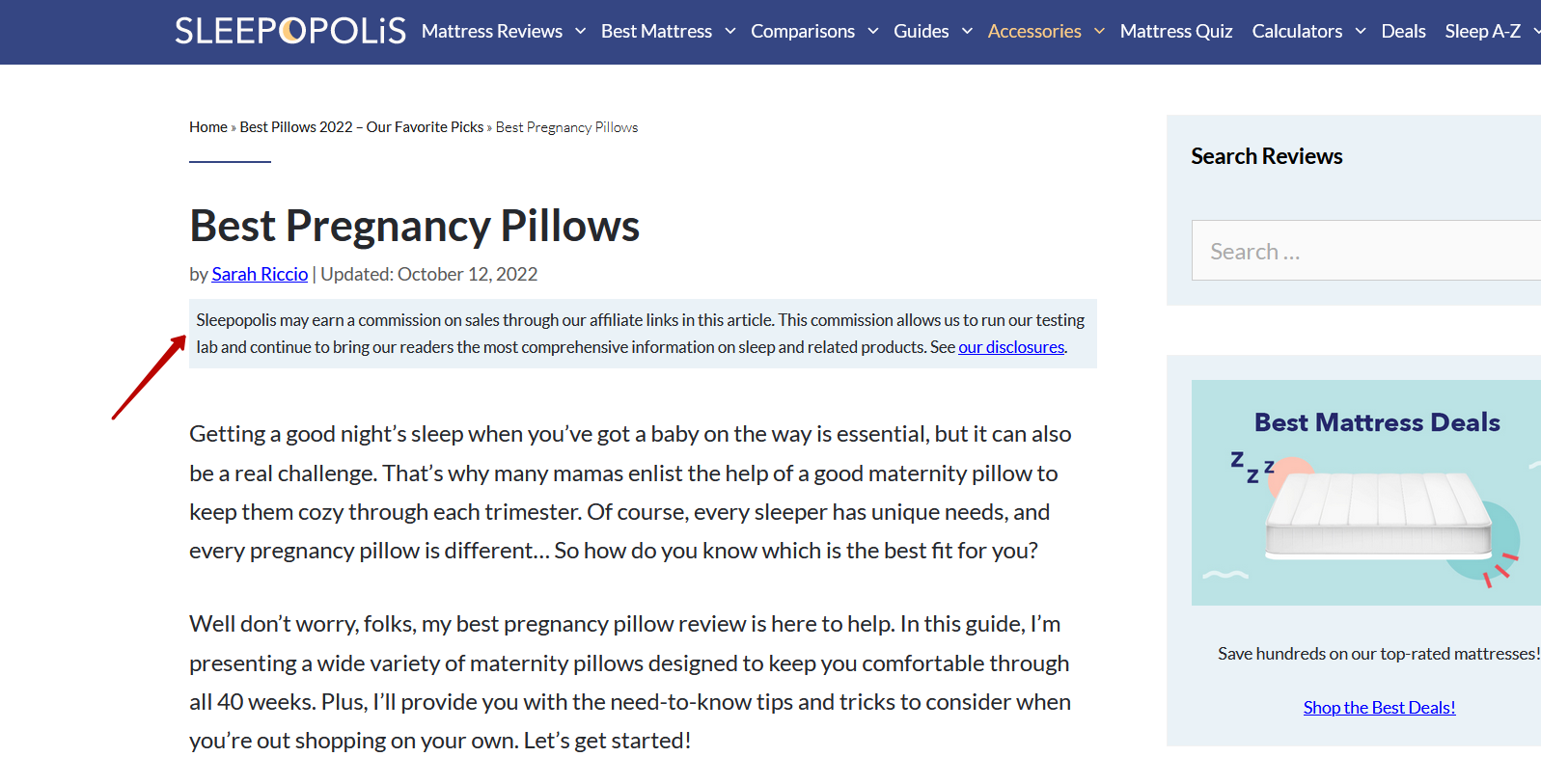

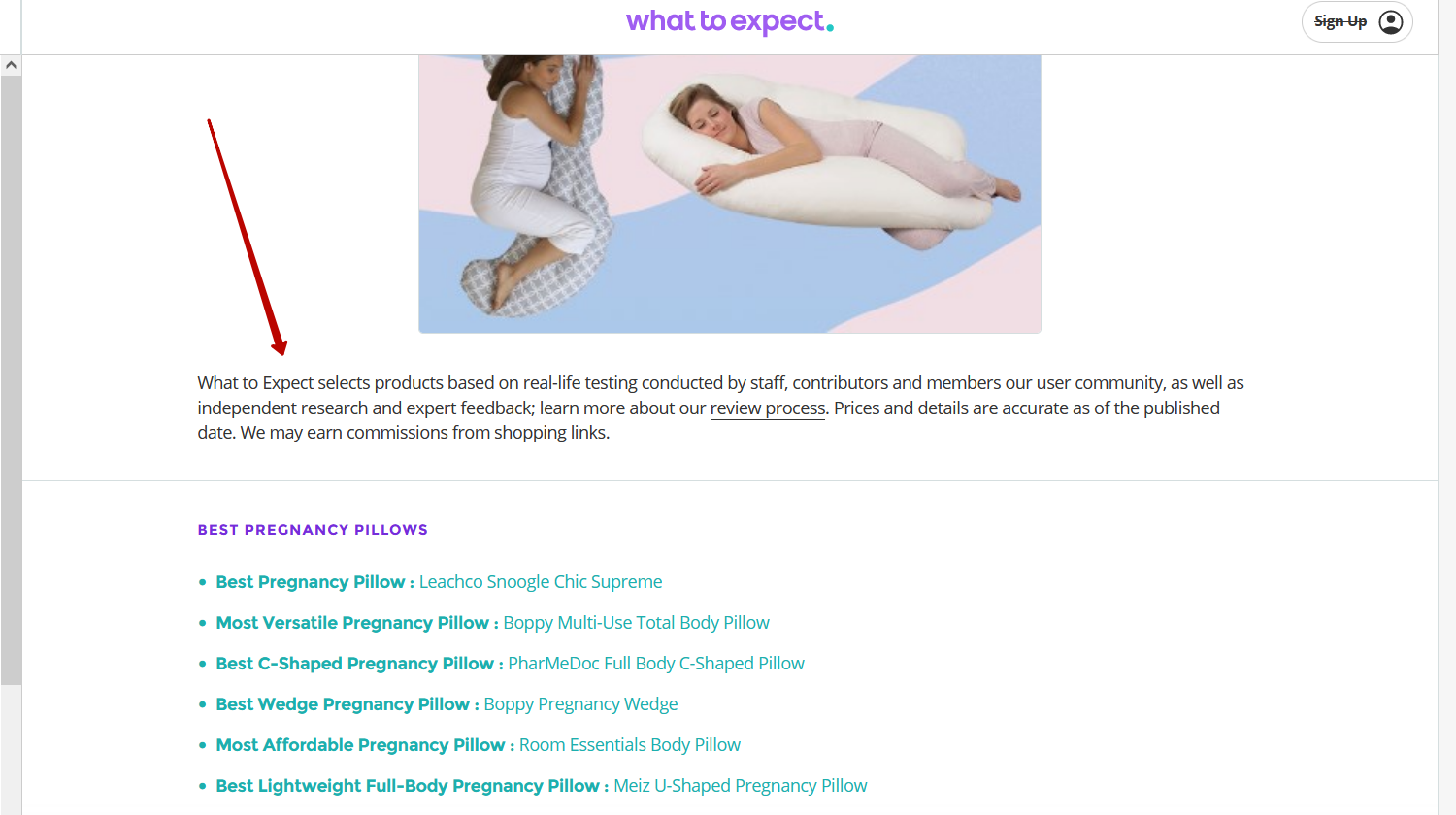

- Проверить есть ли все нужные блоки на сайте (О нас, авторы, контакты, куки нотис, дисклошуры, термсы).

- Добавить подобные строки по аналогии вверх контента:

(Удобно через плагин: https://wordpress.org/plugins/ad-inserter/)

- Не бросать сайт. Вводить изменения и мониторить. Затем далее вводить изменения и мониторить. Если 3-5 месяцев ничего не помогло — сменить дизайн темы.

Крайний вариант: переехать на новый домен, например, с тем же названием .COM на .ORG с 301-редиректом. Рекомендую как самый последний вариант и только после того как будут сделаны все возможные изменений (если переклеивать без изменений шансы, что фильтр перенесется на новый домен очень большие).

14. Как правило — просто не хватает мотивации — переждать и делать изменения и бросают. Не стоит бросать. Если не вводить изменений и не делать это в комплексе – фильтр не отпустил. Шанс очень маленький.

Если делать изменения и не бросать = выйдет 99%. Основная проблема в том, что Google становится более медленных для небольших сайтов и скорость реакции на изменения долгая. Поэтому нужно терпение, делать изменения и не сильно держать это в фокусе, а отпустить ситуацию и делать другие проекты. Например, маленький, под небольшую нишу и не сильно конкурентные ГЕО (взяли какую-то небольшую нишу под 1-2 оффера или товара, сделали сайт условно на немецком языке, повторили).

Для простоты понимания можно представить такую вымышленную картину:

Есть 1 000 000 affiliate-сайтов в США, Google думает «а давай наведем шороху и 30% улетают в рандомный полет». Затем мы делаем как можно больше изменений и улучшений, чтобы робот Google видел «ага, ребята ведут работу, сайт постоянно меняется, улучшения есть – отпустим».

Послесловие:

Стратегия Google последних лет — выкашивать по максимум прибыль с рынка в свою пользу и пользу своих партнеров и аффилированных продуктов. Т.к. условные статьи «Best» направлены в первую очередь на заработок владельцев сайтов, а не Google — он их и косит в первую очередь.

Делайте обновления по сайтам и не бросайте. Особенно пока сайты не набрали «жирка» их болтает в Google. Ранее это было исключением из правил, а сейчас это встречается на каждом шагу (особенно в USA).

Наша задача – либо избегать апдейтов вовсе, готовясь заранее, либо вытаскивать сайты, улучшать их и развивать дальше.

За правильными практическими знаниями – велкам в нашу школу https://affiliate.go-in-top.ru/ (внутри все что нужно для старта – от домена, шаблонов, сервисов и под крылом нашей команды, умножите шансы на успех на 1000%). После регистрации вот тут откроется пара бесплатных материалов https://online.go-in-top.ru/teach/control/stream/view/id/653474586 и красивое видео с заработками, но над тизером и маркетингом еще предстоит поработать, пока работаем над качеством материалов и постоянно обновляем.

Как искать способы выйти из-под фильтра Google

P.S. Хороший способ отслеживать факторы, которые помогают преодолеть фильтры (помимо тестов на своих проектах) – это связка Веб.Архива и Ахрефс/СемРаш.

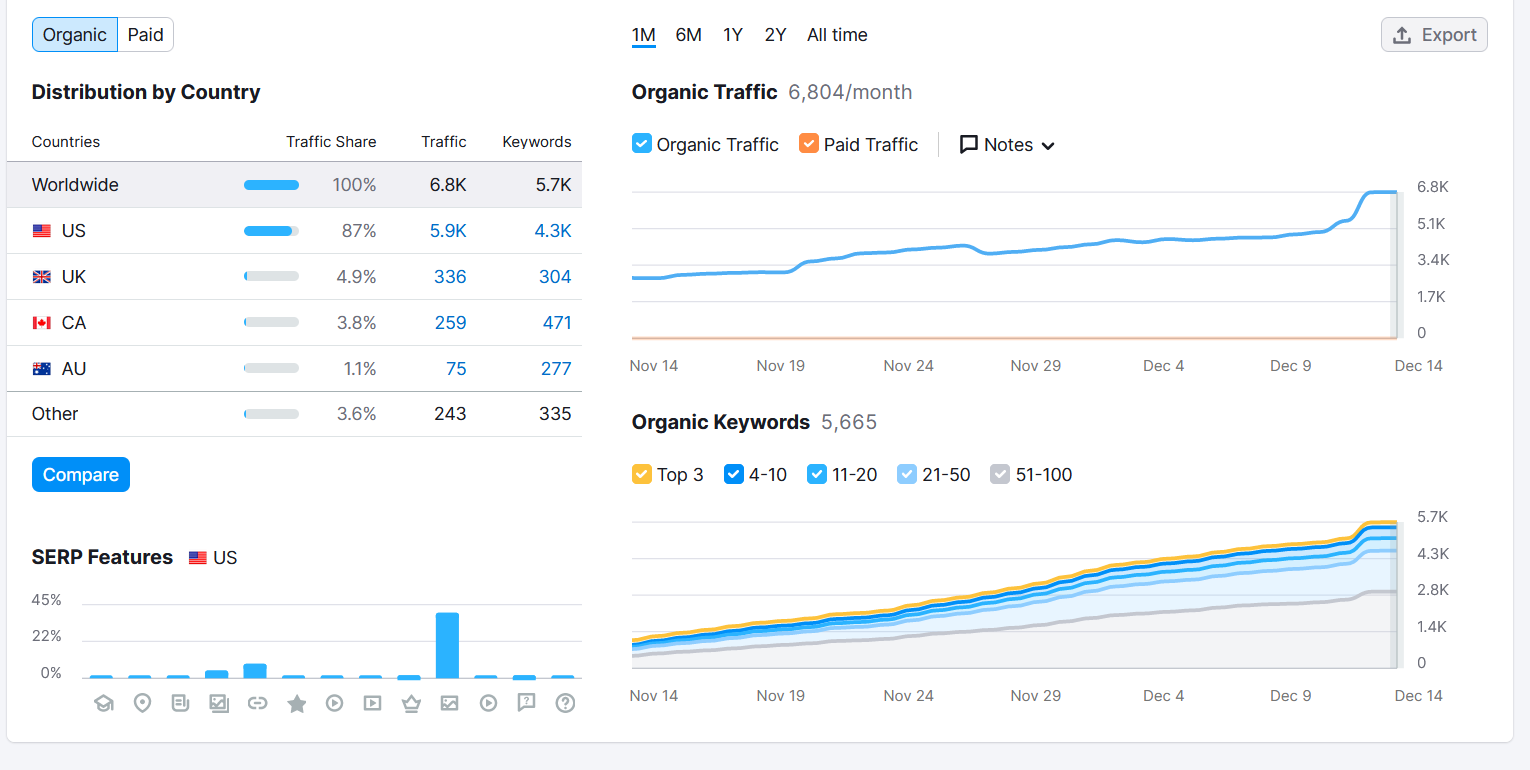

Например: https://www.seedsandspades.com/ — попадает под фильтр одним из летних апдейтов:

Недавно немного начал восстановление:

Новый контент сайт не добавлял (можно сравнить главную страницу сейчас и что было ранее). А вот такие изменения были сделаны: https://www.seedsandspades.com/best-rear-tine-tiller/ VS http://web.archive.org/web/20220811111401/https://www.seedsandspades.com/best-rear-tine-tiller/ — немного освежили цветовую гамму и дизайн, добавили блок автора вниз страницы.

Новый контент сайт не добавлял (можно сравнить главную страницу сейчас и что было ранее). А вот такие изменения были сделаны: https://www.seedsandspades.com/best-rear-tine-tiller/ VS http://web.archive.org/web/20220811111401/https://www.seedsandspades.com/best-rear-tine-tiller/ — немного освежили цветовую гамму и дизайн, добавили блок автора вниз страницы.